Avertissement

Vous lisez une ancienne version de cette documentation. Si vous souhaitez obtenir des informations actualisées, veuillez consulter 5.3 .2.1 Paramètres d’acquisition

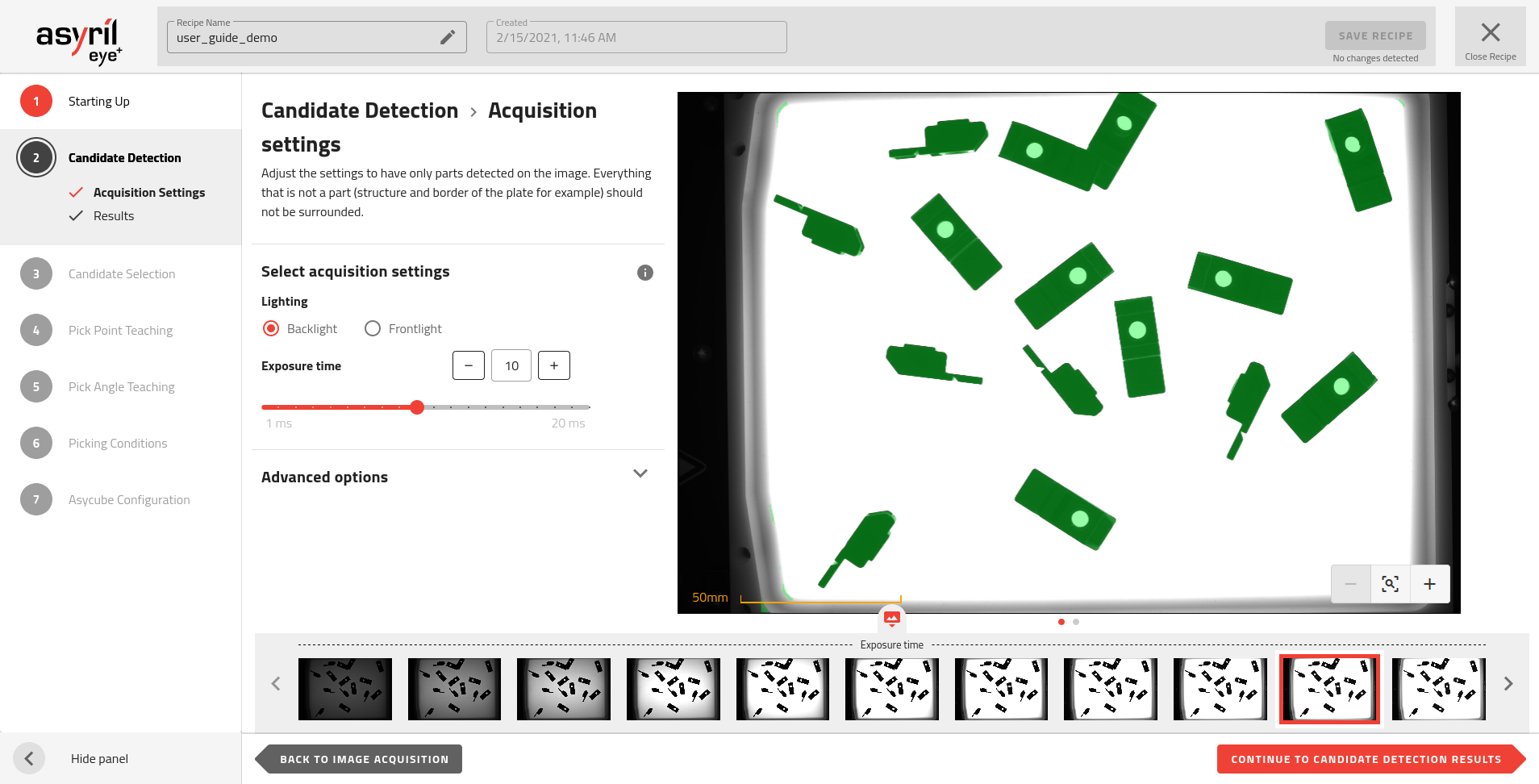

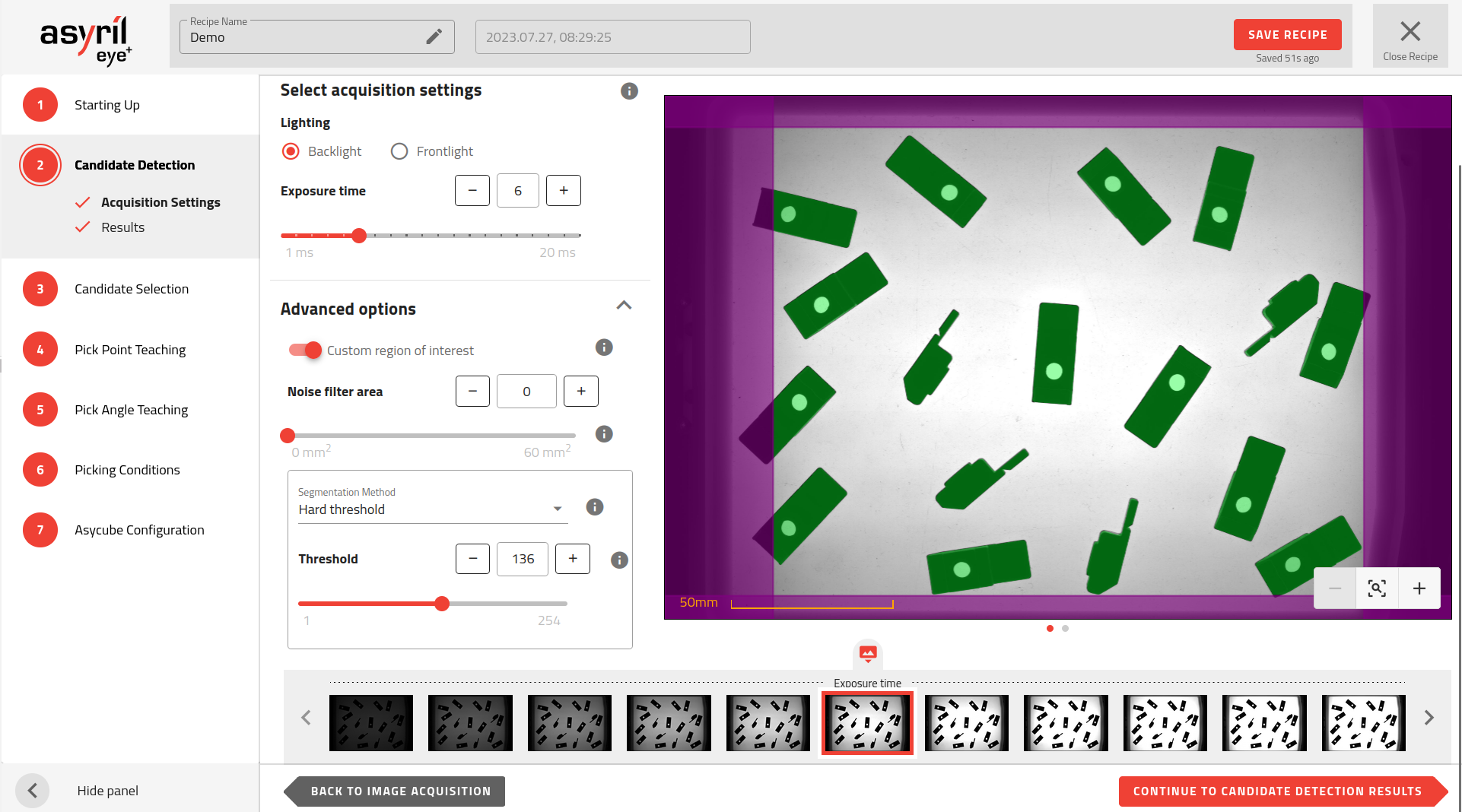

Fig. 56 Détection des candidats - Paramètres d’acquisition

Sélectionner les paramètres d’acquisition

Éclairage

Le type d’éclairage doit être adapté à vos pièces et au type de plateforme de production que vous utilisez. Le choix de l’éclairage doit permettre une bonne détection des pièces et un rejet efficace des éléments indésirables.

Pour une bonne détection des pièces, l’éclairage doit mettre en évidence les bords des pièces. EYE+ détecte les bords des pièces lorsque le contraste entre la pièce et la plateforme de production est élevé.

La plupart des étapes vous permettent de choisir le type d’éclairage et les paramètres que vous souhaitez utiliser, de sorte que vous pouvez sélectionner celui qui donne les meilleurs résultats en fonction de ce que vous voulez voir. Nous vous recommandons toutefois d’utiliser une image rétroéclairée pour l’étape de détection des candidats.

Rétroéclairage

Dans la plupart des cas, l’utilisation du rétroéclairage est suffisante pour la détection des pièces. Ce type d’éclairage met en évidence le contour des pièces, les faisant ressembler à une silhouette, d’où un meilleur contraste entre une pièce opaque et le fond translucide de la plateforme de l’Asycube.

Éclairage frontal

Dans certains cas, il peut s’avérer utile d’utiliser l’éclairage frontal à ce stade de la détection des candidats :

Pièces transparentes: Si vos pièces sont transparentes, l’utilisation de l’éclairage frontal permet aux pièces de refléter la lumière entrante, ce qui augmente le contraste. L’algorithme de détection d’EYE+ sera capable de détecter la pièce si le contraste entre la réflexion de la pièce et l’arrière-plan est suffisamment élevé.

Plateforme de production noire : Afin d’augmenter le contraste entre une pièce et la plateforme de l’Asycube, il peut parfois être utile d’utiliser une plateforme noire combinée à un éclairage frontal.

Remarque

Dans une situation standard, l’utilisation de l’éclairage frontal pourrait mettre en évidence de nombreux éléments indésirables qui n’apparaîtraient pas avec le rétroéclairage. Il sera alors plus difficile de choisir la taille des pièces permettant de ne sélectionner que les candidats souhaités.

Remarque

Si les paramètres d’éclairage que vous souhaitez utiliser ne sont pas disponibles sur cette page, vous pouvez facilement modifier les paramètres d’éclairage pour l’acquisition dans la fenêtre de configuration. Une fois que vous avez modifié ces paramètres, vous devez retourner à la page 1.2 Acquisition d’images et cliquer sur le bouton pour générer de nouvelles images avec les paramètres nouvellement définis.

Démarrage - redémarrer l’acquisition d’images

Temps d’exposition

Le temps d’exposition est le temps durant lequel la caméra est exposée à la lumière lors de l’acquisition des images. Plus le temps d’exposition est long, plus l’image est lumineuse.

L’augmentation ou la diminution du temps d’exposition affecte le contraste entre les pièces et la plateforme de production. Vous devez trouver le temps d’exposition optimal pour la détection des pièces.

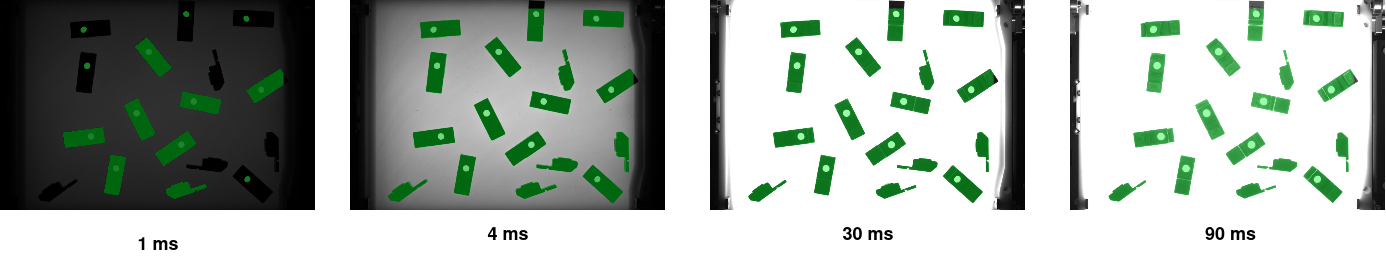

Fig. 57 Images avec des temps d’exposition différents en utilisant le rétroéclairage

Fig. 58 Images avec des temps d’exposition différents en utilisant l’éclairage frontal

Temps d’exposition trop court

L’algorithme de détection d’EYE+ pourrait ne pas détecter les pièces s’il ne peut pas déterminer la différence entre la pièce et l’arrière-plan. Ceci se produit principalement quand les pièces se trouvent à proximité des bords de la plateforme.

L’algorithme de détection d’EYE+ pourrait détecter des éléments indésirables tels que des formes ou des ombres de la plateforme de production.

Temps d’exposition trop long

Une image sursaturée pourrait éroder les bords des pièces. La taille des pièces pourrait alors être différente d’une position à l’autre dans l’image. La détection ne sera alors pas assez robuste pour les pièces de petite taille.

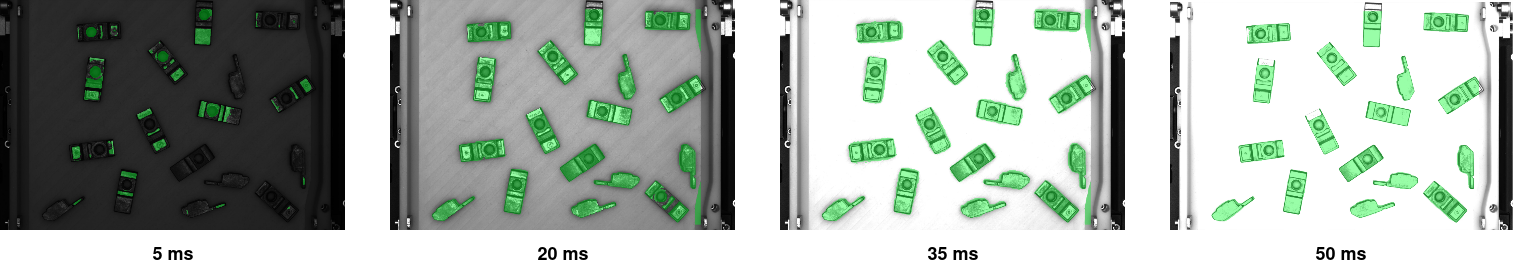

Options avancées

Les options avancées fournissent des paramètres supplémentaires qui peuvent être ajustés dans le cas où les paramètres de détection par défaut ne donnent pas d’assez bons résultats, par exemple lorsqu’on utilise une plateforme structurée et que la texture de la plateforme est détectée en tant que pièces.

Fig. 59 Les options avancées peuvent être affichées en cliquant en haut à droite du titre.

Important

En regardant l’image de segmentation, vous devriez dans l’idéal voir toutes les pièces en blanc et tout le reste en noir. Cette image de segmentation sera ensuite utilisée pour repérer d’éventuelles collisions entre les pièces. Il est donc important que le moins de bruit possible apparaisse sur l’image et que les vraies pièces soient détectées avec succès.

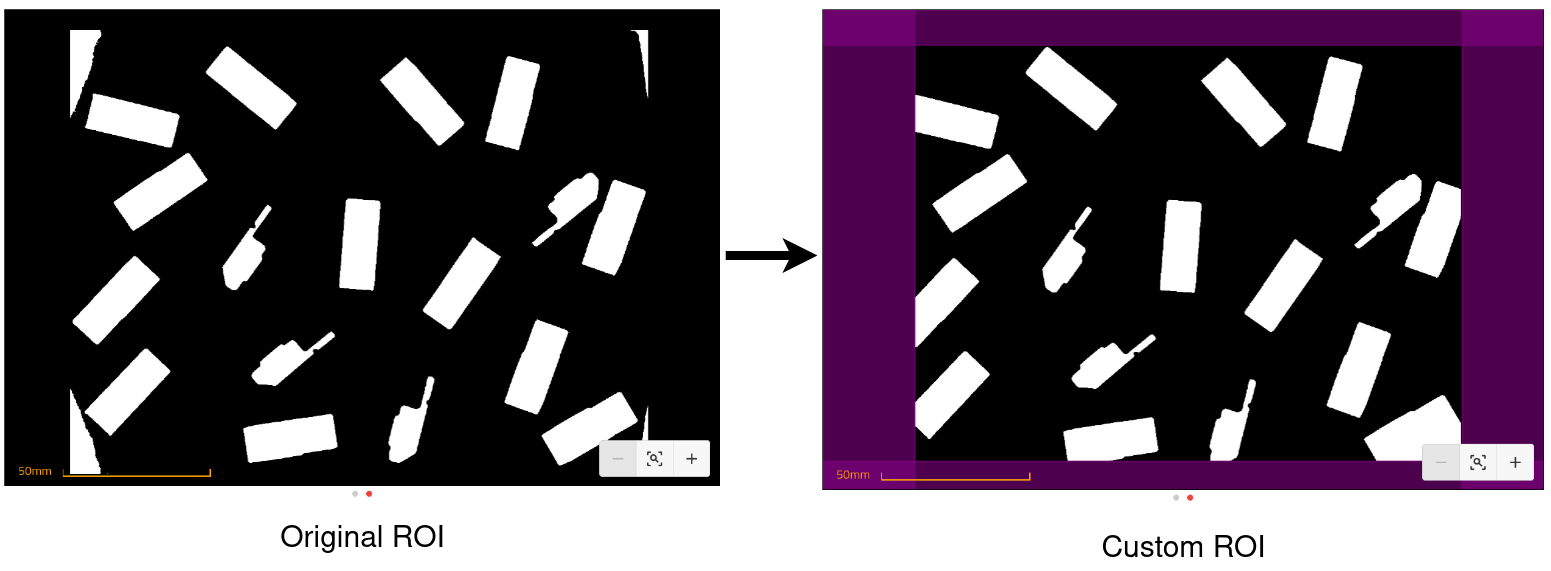

Région d’intérêt personnalisée (ROI)

Par défaut, EYE+ utilise la même ROI lors de la définition d’une recette que celle définie par le processus d’étalonnage de la vision. Vous pouvez cependant souhaiter modifier cette option pour restreindre la zone dans laquelle EYE+ recherchera des candidats. L’activation de cette option vous permettra de déplacer des barrières virtuelles afin de modifier la ROI utilisée pour le reste de la recette. La désactivation de cette option rétablira la ROI par défaut, toute ROI personnalisée que vous aurez définie sera perdue.

Fig. 60 Définition d’une région d’intérêt personnalisée.

Conseil

Ceci est particulièrement utile lorsque les paramètres requis pour détecter correctement vos pièces font que les bords de la plateforme sont détectés comme candidats.

Fig. 61 Effets d’une région d’intérêt personnalisée sur l’image de segmentation.

Important

La modification de la ROI affecte l’image de segmentation, ce qui signifie qu’elle a un impact sur le calcul du pourcentage de remplissage de la plateforme. Cela peut avoir un effet sur le comportement des actions de centrage intelligent et d’alimentation intelligente.

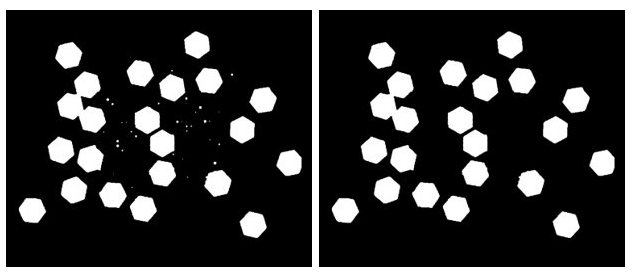

Aire de filtre du bruit

Ce paramètre permet de filtrer le bruit en supprimant tout ce qui est plus petit que la surface définie. Selon la configuration de la caméra, cette surface est exprimée en unité calibrée ou en pixels.

Fig. 62 Image de segmentation avec différentes valeurs pour l’aire du filtre du bruit. Gauche : 0px, Droite : 450px.

Conseil

Il est plus facile de voir s’il y a du bruit sur l’image en éxaminant l’image de segmentation. Vous pouvez changer d’image en cliquant sur les boutons de navigation situés sous l’image.

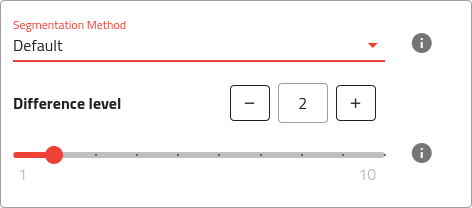

Méthode de segmentation

La segmentation peut être effectuée à l’aide de plusieurs méthodes. EYE+ supporte actuellement 2 méthodes :

Défaut

Seuil fixe

Défaut

Méthode de segmentation optimisée qui fonctionnera pour la plupart des pièces, sans qu’il soit nécessaire d’ajuster aucun paramètre.

Fig. 63 Méthode de segmentation par défaut avec les paramètres disponibles.

Niveau de différence

Le niveau de différence est la différence d’intensité maximale entre un pixel et ses voisins pour considérer ce nouveau pixel comme appartenant à la même pièce. Le niveau de différence par défaut est de 2. L’augmentation de cette valeur rendra les bords des pièces plus nets mais peut également éroder le contour.

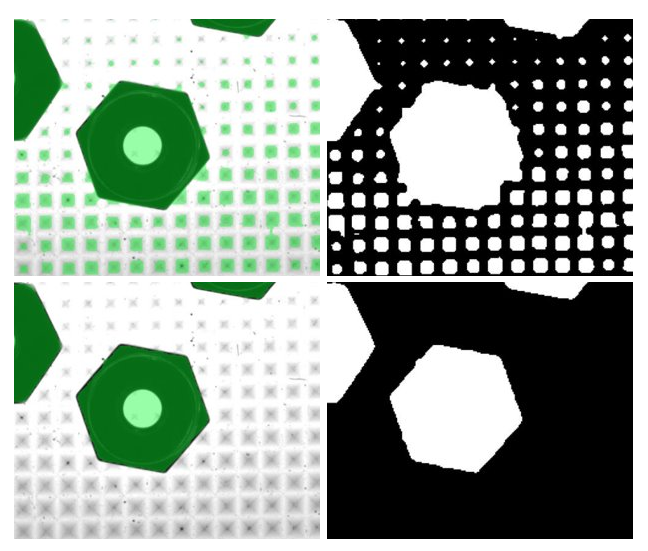

Fig. 64 Gros plan d’une pièce sur une plateforme pyramidale (à gauche : résultat avec superposition, à droite : image de segmentation) en utilisant différents niveaux de différence (en haut : niveau de différence de 2, en bas : niveau de différence de 10).

Conseil

Lorsque vous modifiez cette valeur, faites particulièrement attention à ce que les parties proches des bords ne disparaissent pas. Si cela se produit, essayez d’augmenter le temps d’exposition ou de diminuer le niveau de différence.

Seuil fixe

Cette méthode appliquera le seuil défini pour différencier la plateforme de l’arrière-plan. Cela fonctionne bien sur les images où le niveau d’intensité des pièces diffère beaucoup du niveau d’intensité de l’arrière-plan.

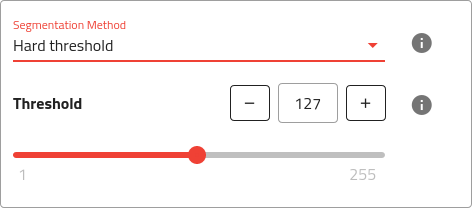

Fig. 65 Méthode de segmentation avec seuil fixe avec les paramètres disponibles.

Conseil

Le seuil fixe peut être mieux adapté aux pièces nécessitant une plateforme avec des rainures ou des trous.

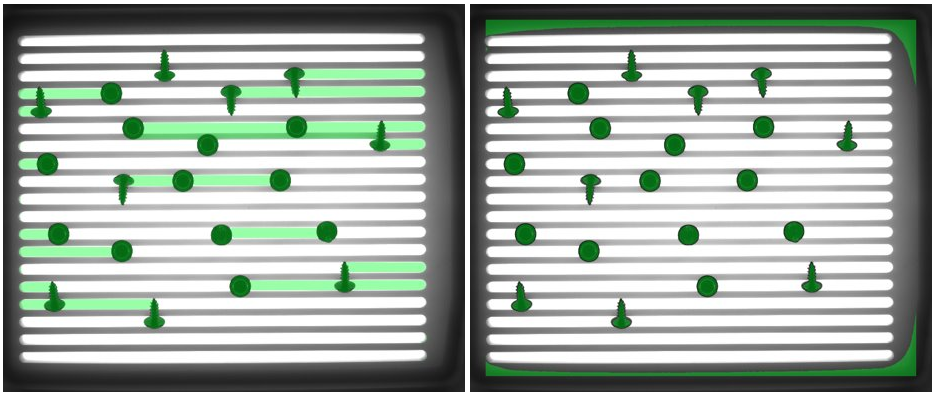

Fig. 66 Pièce sur une plateforme avec des rainures. Dans ce cas, la méthode du seuil fixe fonctionne mieux. À gauche : méthode par défaut, à droite : méthode du seuil fixe.

Important

Cette méthode utilise un seuil fixe et est donc sensible aux changements de luminosité sur l’image. Assurez-vous que la lumière ambiante n’affecte pas trop l’image lorsque vous utilisez cette méthode.

Remarque

En utilisant cette méthode, il est difficile d’éviter que certaines zones de l’arrière-plan soient détectées comme des candidats potentiels (blanc dans l’image de segmentation), en particulier près des bords de la plateforme. Il s’agit donc d’une limitation de cette méthode.

Seuil

Seuil d’intensité (entre 1 et 255). Réglez le seuil de manière à ce que seules les pièces soient détectées.

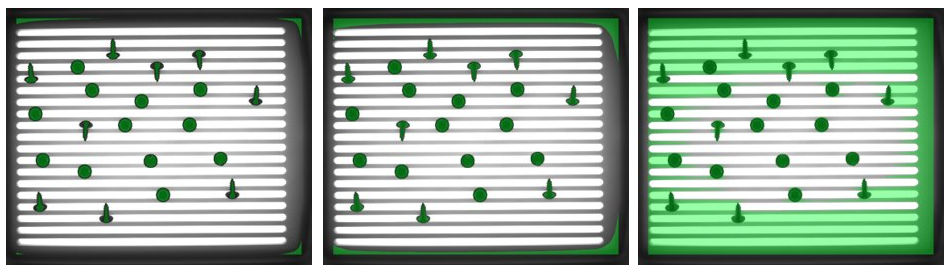

Fig. 67 Résultat avec différents seuils. Gauche : Seuil trop bas (les pièces sont érodées), Milieu : Bon seuil, Droite : Seuil trop élevé (les pièces ne sont pas séparées de l’arrière-plan).